O disco rígido, popularmente conhecido como HD (Hard Disk), é um dispositivo que é usado em computadores capaz de armazenar dados. No HD é armazenado qualquer tipo de informação, podendo ser um simples arquivo de uso pessoal, como também informações usadas pelo sistema operacional.

As informações contidas no HD não são perdidas ao ser desligada a máquina, por ser considerado uma memória não-volátil. No HD está o registro de todos os arquivos possíveis que existam em um computador, como imagens, vídeos, planilhas, programas, etc.

Acredita-se que o primeiro HD tenha surgido no ano de 1956, e tinha capacidade de armazenamento de 5 MB de dados. O IBM 305 RAMAC, como foi chamado este HD, possuía dimensões enormes: 14 X 8 polegadas. Outra característica importante desse HD é o seu preço, custava em média 30 mil dólares. Ao longo dos anos a estrutura desse tipo de equipamento mudou muito, atualmente existem vários modelos, porém, o tamanho acabou diminuindo muito. A capacidade de armazenamento também foi aperfeiçoada ao longo tempo.

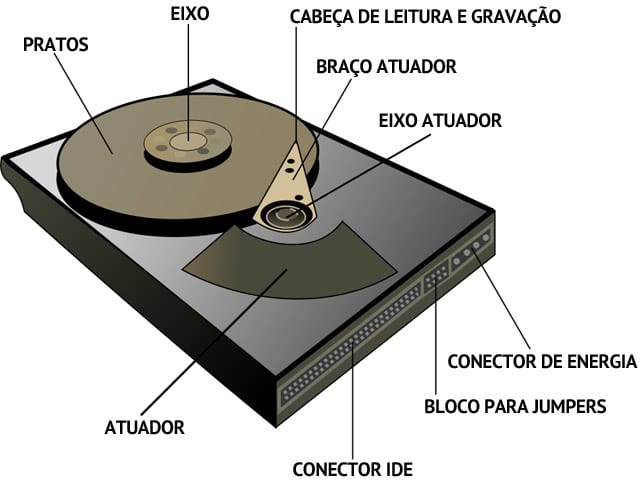

Considerando que um HD possui o braço, eixo, disco (também chamado de prato), cabeça de leitura e gravação e ainda o atuador, o seu funcionamento se dá através da movimentação desses itens descritos.

Os pratos de um HD são onde os discos são armazenados, no geral, são de alumínio recoberto por um material magnético e por mais uma camada de material protetor. Assim, quanto mais for trabalhado o material magnético, maior será a sua capacidade de armazenamento do disco.

Esses discos ficam posicionados sob o eixo, que é responsável por fazê-los girar. Nos HDs também possui um dispositivo chamado de cabeça, ou cabeçote, de leitura e gravação. O seu tamanho é bastante pequeno, nele contém uma bobina que usa impulsos magnéticos para que as moléculas possam se movimentar sobre o disco e assim gravar os dados. Nos modelos de HDs mais modernos, a cabeça de gravação conta com dois componentes, um responsável pela gravação e outro direcionado à leitura.

O atuador presente na estrutura do HD é responsável por mover o braço acima da superfície dos pratos e com isso permitir que as cabeças façam o seu trabalho. Para que a movimentação sai de forma correta, o atuador conta em seu interior uma bobina que é "induzida" por imãs.

A parte responsável por todo o armazenamento de dados são os discos magnéticos, na qual são formadas por duas partes, a primeira delas é chamada de substrato. Porém, o HD não armazena os dados em um disco metálico, na qual tem finalidade de proporcionar um instrumento gravável, deste modo estes discos são recobertos por camadas de substâncias magnéticas, dando origem ao nome de "discos magnéticos".

Apesar dos discos magnéticos serem considerados extremamente frágeis, eles são bastante resistentes. Eles são montados em eixo que os faz sofrer rotação em alta velocidade.

O responsável pela leitura e também gravação de dados sobre o disco magnético é chamado de "cabeça de leitura”. A cabeça de leitura posiciona um leitor (uma espécie de “agulha") sobre os discos magnéticos para ler ou gravar dados. Esses dados são lidos e gravados sem que a agulha encoste no disco. Isso só acontece porque o HD é hermeticamente fechado e em consequência à alta velocidade em que o disco é submetido, a cabeça de leitura acaba sendo jogada para cima.

O atuador é uma peça que movimenta a cabeça de leitura em torno do disco e ele funciona por atração/repulsão magnética.